过去几年人工智能的稳步崛起,以及自 OpenAI 于 2022 年 11 月推出 ChatGPT 以来,随着生成式人工智能的引入而加速增长,已经改变了英特尔作为其长期主导的芯片市场挑战者的地位。

当然,英特尔仍然占据着消费者和企业 CPU 空间的很大比例,但现在和未来的重点是人工智能工作负载。此外,人工智能并不是英特尔不再像以前那样拥有该行业的唯一原因——导致成本高昂且令人尴尬的产品延迟的内部设计和制造挑战也无济于事——云计算和边缘计算等趋势开辟了途径对于传统竞争对手和初创公司来说都是如此。但十多年前,英伟达将所有资金投入人工智能,将其作为未来创新的北极星。

正如我们在 2 月份指出的那样,它得到了回报,而且回报丰厚,这家 GPU 制造商即将成为一家价值 1000 亿美元的公司,并公布 2024 年第四季度收入为 221 亿美元,同比增长 265.3%通过其硬件和软件的结合。与此同时,本月早些时候,英特尔重要的代工业务遭受了 70 亿美元的损失,这说明了首席执行官帕特·基辛格 (Pat Gelsinger) 面临的障碍,因为他多年来一直在努力让公司朝着正确的方向发展。

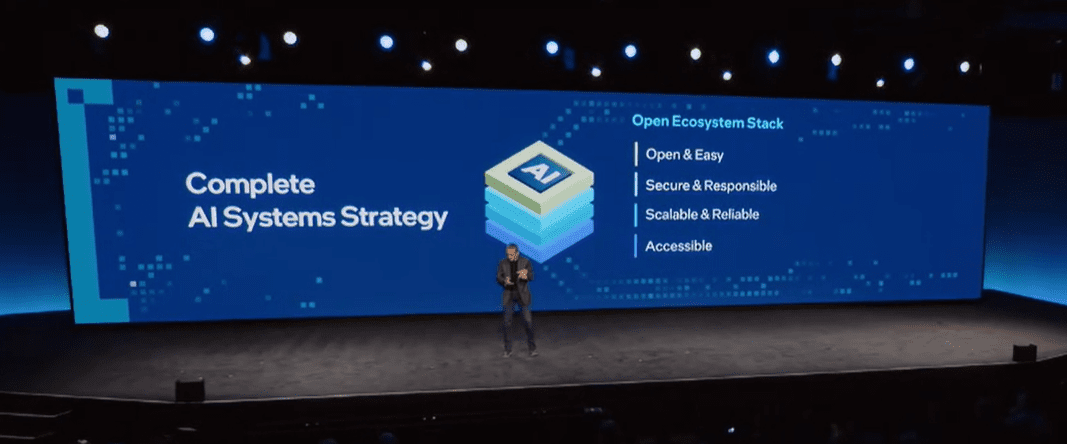

基辛格在亚利桑那州举行的英特尔 2024 年愿景活动上发表主题演讲时,并没有削弱他标志性的热情,他似乎很享受失败者的角色,因为他提出了一个路线图,以推动英特尔推动人工智能无处不在的愿景,其中包括拥抱开放的源方法,承诺芯片将超越 Nvidia 在市场上的产品,并提供可解决数据中心和云、PC 和边缘的 AI 工作负载的产品组合。

开放架构和英特尔

这位首席执行官还表示,人工智能市场将以一种有利于英特尔的方式发展,并指出需求将转向开放平台,以及英特尔从主要人工智能和 IT 公司获得的大力支持,并认为企业将希望坚持使用一种架构几十年来,他们已经熟悉了是否能够提供与 Nvidia 相同或更好的 AI 性能和效率。

事情是否会这样还不清楚,但基辛格在介绍即将推出的最新一代 Xeon 服务器芯片(Xeon 6 系列)和Gaudi 3 AI 加速器并谈到开放系统战略时,正在采取行动。

“我们的人工智能客户问我们的关键问题之一是,‘我如何部署?’”他说。 “如今几乎所有 GenAI 部署的开发都正在转向更高级别的环境、PyTorch 框架和 Hugging Face 的其他社区模型。业界正在迅速放弃专有的 [Nvidia] CUDA 模型。从字面上看,只需几行代码,您就可以在高性能、高效的云基础设施上启动并运行行业标准框架。”

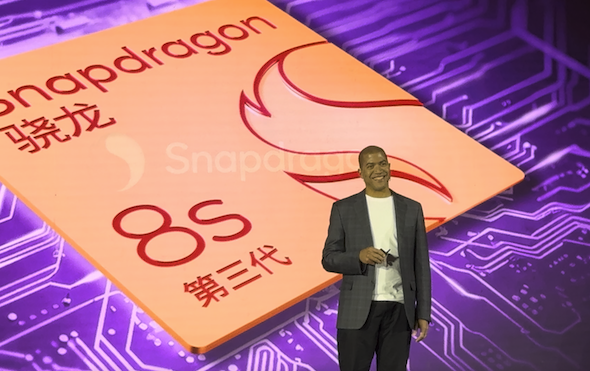

英特尔还有一座山要爬。 Gaudi 3 是在 Nvidia 上个月推出Blackwell 数据中心 GPU之后推出的,其中包括GB200 Grace Blackwell Superchip,该芯片将两个 B200 GPU 与一个通过下一代 NVLink 连接连接的 Grace CPU 结合在一起。为了证明 Blackwell 的进步,Nvidia 创始人兼首席执行官黄仁勋在该公司的 GTC 2024 展会上表示,需要 8,000 个以前的 Hopper GPU 和 15 兆瓦的功率来训练一个 1.8 万亿参数的 AI 模型;使用 Blackwell,只需要 2,000 个加速器,并且消耗 4 兆瓦。

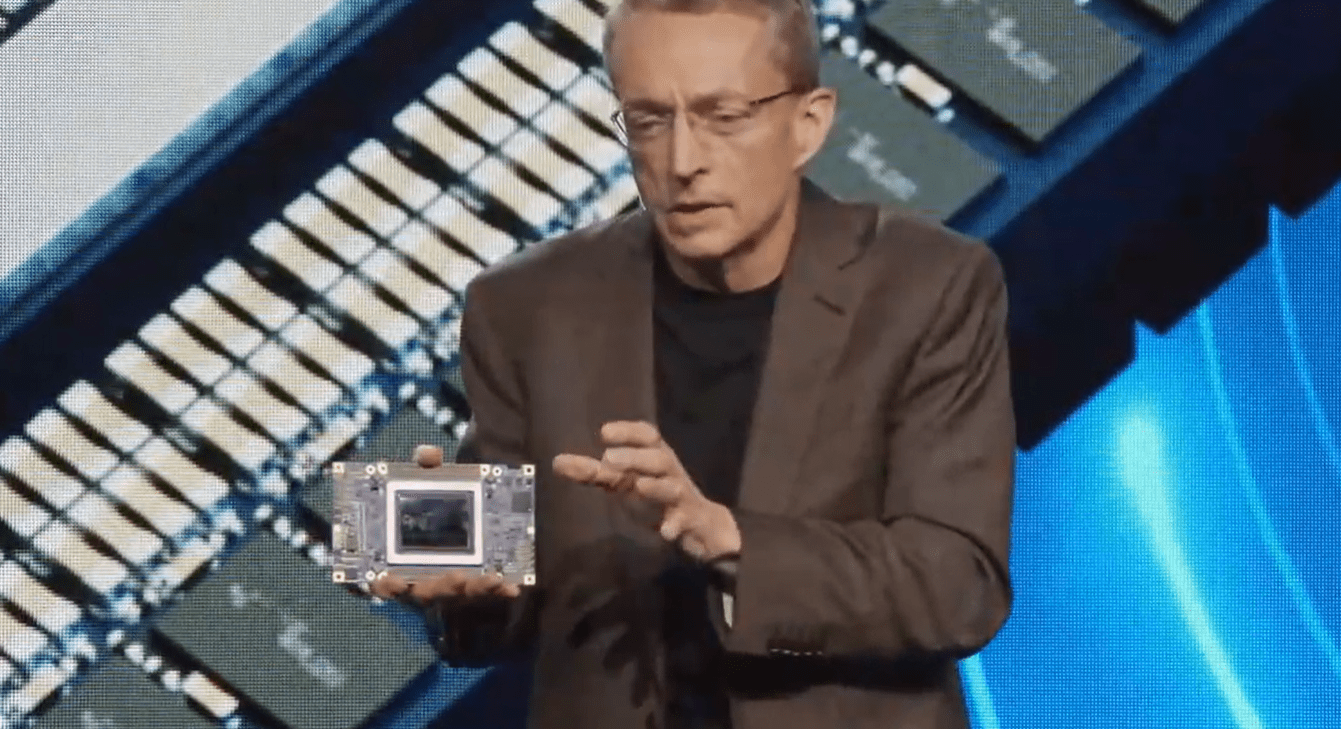

GAUDI 3:以更低的成本获得更好的性能

基辛格反驳道,夸耀了 Gaudi 3 的性能和 TCO。与 Nvidia 当前的加速器相比,这些加速器的推理性能提高了 50%,能效提高了 40%,而且考虑到 AI 工作负载对计算能力的需求猛增,H100 有时很难找到,并且将以“一小部分”的价格投入使用。成本。

基辛格在主题演讲后与记者和分析师交谈时表示,他还没有准备好讨论 Gaudi 3 的定价,但他补充说,“我们非常有信心它的价格将远低于 H100 或 Blackwell 的价格。不是低一点,而是低很多,这可能是 TCO 的一个因素。”

适用于数据中心、云和边缘的最新 CPU 的新 Xeon 6 品牌。配备 E 核心的“Sierra Forrest”将于本季度晚些时候推出,而“Granite Rapids”及其性能核心也将很快推出。英特尔宣称,与采用 Sierra Forest 的第二代 Xeon 相比,每瓦性能提高了 2.4 倍,机架密度提高了 2.7 倍。

Gelsinger 再次将 CPU 定位为 Nvidia 高性能 GPU 和 CUDA 框架的同等性能且更开放的替代品。新的 Xeon 支持 MXFP4 数据格式,他将其描述为一种更窄的格式,可以实现内存压缩、高效的 AI 训练和 AI 推理, “精度损失最小”。借助 MXFP4,Granite Rapids 将能够比使用 FP16 的第四代 Xeon 减少高达 6.5 倍的下一个令牌延迟,从而使其能够运行 700 亿参数的 Llama-2 模型。

喜欢你周围的建筑

对于长期在数据中心使用至强处理器、熟悉英特尔架构并倾向于开放环境的企业来说,这将具有吸引力。

“你的数据、你的数据堆栈以及几乎每一个数据堆栈都运行在 Xeon 上,”他说。 “这是数据库运行的地方,令人惊讶的是,我们正处于云之旅的第 22 年左右,大部分(超过 60%)的计算是在云或某些云实施例中完成的,但绝大多数数据仍在本地。 66% 的数据未使用,90% 的非结构化数据未使用。”

企业可以通过采用检索增强生成 (RAG) 技术,将企业信息包含在用于训练大型语言模型的数据中,来处理这些未使用的 AI 本地数据。

“至强显然是一台巨大的机器,可以运行这些 RAG 环境,并使法学硕士对数据更加有效和高效,”Gelsinger 说。 “Xeon 不仅能够成为您的数据库前端,而且越来越能够运行 LLM。没有新的管理、没有新的网络、没有新的安全模型、没有新的 IT 知识需要学习、没有专有网络。它只适用于您熟悉和喜爱的行业标准 Xeon。”

首席执行官表示,开放架构以及硬件和软件系统将是关键。

“我们清楚地看到,人们对如何推动这些标准的发展很感兴趣——标准管理、无网络锁定、无安全问题、与本地运行在 Xeon 上的法学硕士合作,也与 Gaudi 2 和 3 以及 Nvidia 合作,”他说。 “现在是为企业人工智能构建开放平台的时候了。我们正在努力解决关键需求,包括如何使用现有基础设施进行高效部署,与现有的强化企业软件堆栈无缝集成,以及高度的可靠性、可用性、安全性和支持问题。”