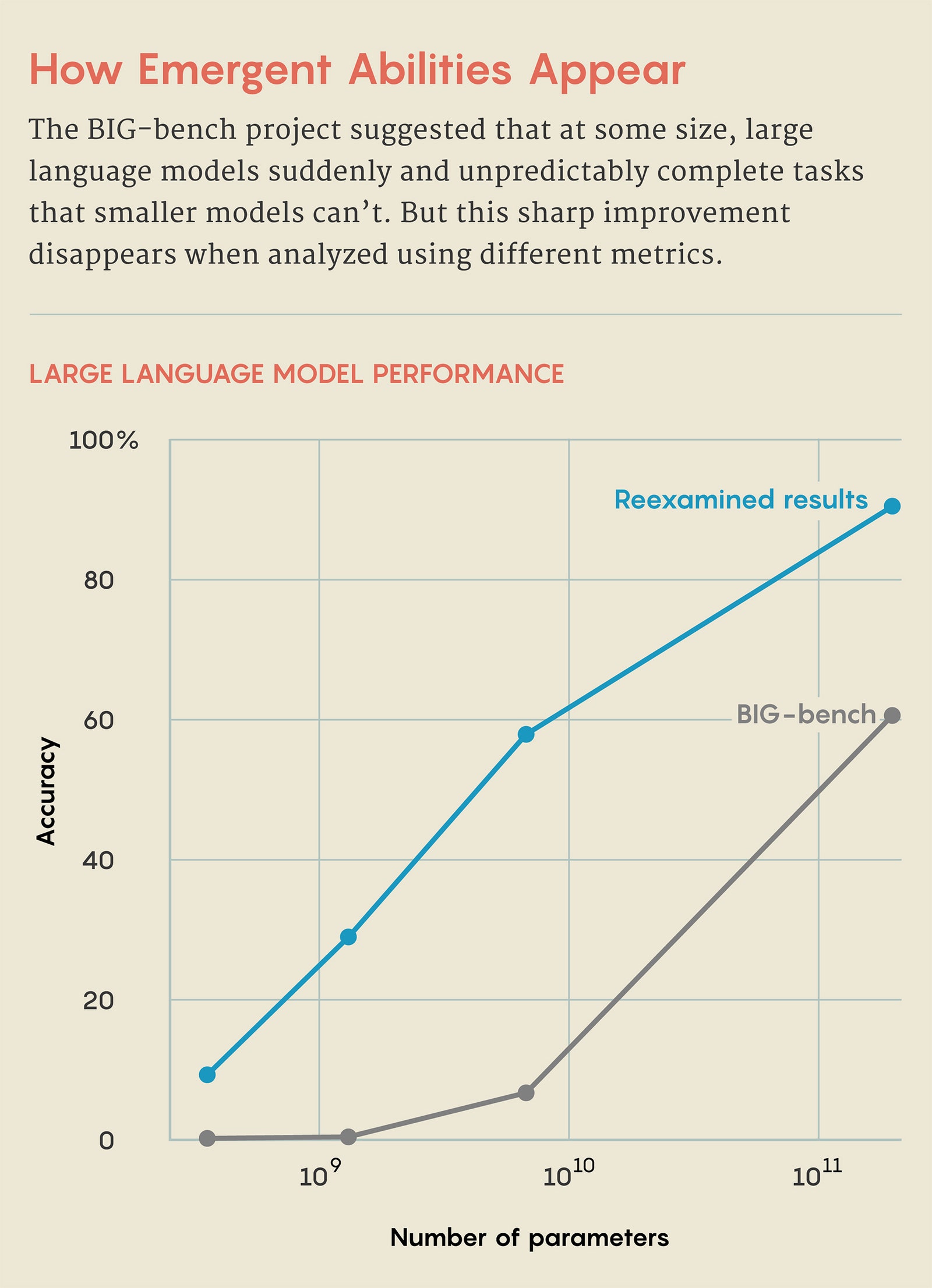

两年前,在一个名为Beyond the Imitation Game benchmark (BIG-bench)的项目中,450 名研究人员编制了一份包含 204 项任务的列表,旨在测试大型语言模型的功能,这些模型为 ChatGPT 等聊天机器人提供支持。在大多数任务中,随着模型规模的扩大,性能可预测且平稳地提高——模型越大,性能就越好。但在其他任务中,能力的提升并不顺利。性能一度保持在零附近,然后性能猛增。其他研究也发现了类似的能力飞跃。

作者将此描述为“突破性”行为;其他研究人员将其比作物理学中的相变,就像液态水冻结成冰一样。在 2022 年 8 月发表的一篇论文中,研究人员指出,这些行为不仅令人惊讶,而且不可预测,它们应该为围绕人工智能安全、潜力和风险不断发展的对话提供信息。他们将这些能力称为“涌现”,这个词描述了只有在系统达到高度复杂性时才会出现的集体行为。

但事情可能没那么简单。斯坦福大学三位研究人员在一篇新论文中指出,这些能力的突然出现只是研究人员衡量法学硕士表现方式的结果。他们认为,这些能力既不是不可预测的,也不是突然出现的。 “这种转变比人们想象的更容易预测,”斯坦福大学计算机科学家、该论文的资深作者桑米·科耶乔 (Sanmi Koyejo)说。 “对出现的强烈主张与我们选择的衡量方式有关,与模型正在做什么有关。”

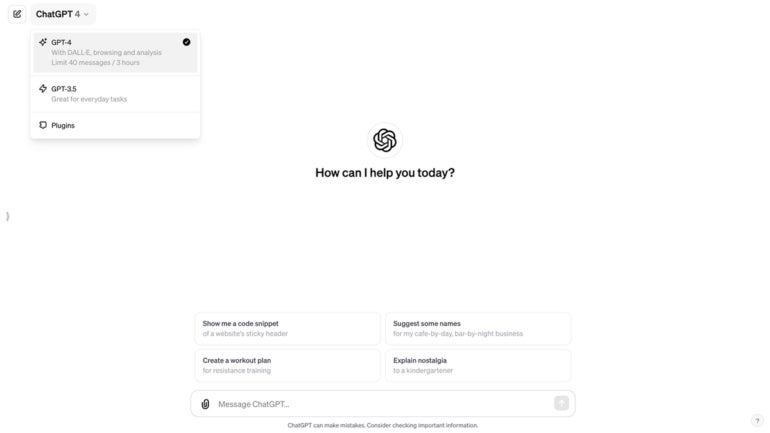

由于这些模型变得如此庞大,我们现在才看到并研究这种行为。大型语言模型通过分析大量文本数据集(来自书籍、网络搜索和维基百科等在线资源的单词)并查找经常一起出现的单词之间的链接来进行训练。大小是用参数来衡量的,大致类似于单词连接的所有方式。参数越多,法学硕士可以找到的联系就越多。 GPT-2 有 15 亿个参数,而支持 ChatGPT 的 LLM GPT-3.5 使用了 3500 亿个参数。 GPT-4 于 2023 年 3 月首次亮相,现在是Microsoft Copilot 的基础,据报道使用了 1.75 万亿美元。

这种快速增长带来了性能和效率的惊人飙升,而且没有人质疑足够大的法学硕士可以完成较小模型无法完成的任务,包括那些未经训练的任务。斯坦福大学的三人将出现视为“海市蜃楼”,他们认识到法学硕士随着规模的扩大而变得更加有效;事实上,较大模型增加的复杂性应该能够更好地解决更困难和多样化的问题。但他们认为,这种改进是否看起来平滑且可预测,或者锯齿状且尖锐的结果取决于指标的选择(甚至是测试示例的缺乏),而不是模型的内部运作。

三位数加法提供了一个例子。在 2022 年的 BIG-bench 研究中,研究人员报告称,在参数较少的情况下,GPT-3 和另一位名为 LAMDA 的法学硕士都未能准确完成加法问题。然而,当 GPT-3 使用 130 亿个参数进行训练时,它的能力就像按下开关一样发生了变化。突然之间,它可以添加参数,LAMDA 也可以添加 680 亿个参数。这表明添加能力在一定阈值时出现。

但斯坦福大学的研究人员指出,法学硕士的评判标准只是准确性:要么他们能完美地完成任务,要么不能。因此,即使法学硕士正确预测了大部分数字,它也失败了。这似乎不对。如果您计算 100 加 278,那么 376 似乎是比 -9.34 更准确的答案。

因此,Koyejo 和他的合作者使用授予部分学分的指标测试了相同的任务。 “我们可以问:它对第一位数字的预测效果如何?那么第二个呢?那么第三个呢?”他说。

Koyejo 将这项新工作的想法归功于他的研究生 Rylan Schaeffer,他说他注意到法学硕士的表现似乎会随着其能力的衡量方式而变化。他们与另一位斯坦福大学研究生布兰多·米兰达 (Brando Miranda) 一起选择了新的指标,表明随着参数的增加,法学硕士在其他问题中预测的数字序列越来越正确。这表明,添加的能力不是突然出现的——这意味着它会经历突然的、不可预测的跳跃——而是渐进的和可预测的。他们发现,用不同的衡量标准,涌现就会消失。